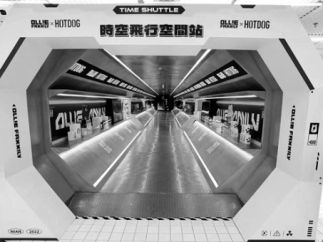

元宇宙是物理世界和数字世界的虚实融合

元宇宙已经开始准备跨越裂谷了。元宇宙不是物理的宇宙,而是一个社会。在这个虚拟社会里,发展最快的是社会关系,也就是社交互动;其次是经济关系,主要通过NFT来表达,所以现在NFT发展得很快,不久就能跨越裂谷了;第三个方面是生产关系,在该领域元宇宙已经开始有一些变化。

未来到底是什么样的元宇宙世界?我们认为它将是物理世界和数字世界的虚实融合,产生各种应用,并在未来改变相应的生产关系,包括虚实融合的旅游、购物、协作、娱乐、工作空间、仿真训练等。在这些空间里,采用的技术可能比较重要。对华为来讲,我们研究应用少一点,更多的是研究偏底层的技术。

元宇宙的核心能力包括:算力能力,媒体能力、网络能力、智能交互能力和空间能力。这些核心能力需要底层扎实的基础设施来支撑。

我今天给大家介绍的就是关于元宇宙基础设施的需求。

#02

云将成为整个“元宇宙世界”的运行平台

算力

虚实融合对算力的消耗非常大,需要海量算力的支撑,它不可能通过单台服务器或单台设备来实现,必须通过云的方式来支持。对于元宇宙而言,要想变得更逼真,它对算力的要求更大,大部分的算力消耗在图形渲染和视频上,视频的本质也是图形渲染。随着直播的发展,我们推测未来视频可能会从单向流量转发走向视频实时互动。

根据我们对直播和点播业务的分析,它主要的消耗是在计算、存储和网络三方面,也就是IT三大基础设施。其中,网络占了70%,主要是带宽以及CDN流量;计算和存储分别占了10%和15%。等到了未来,中心存储变得非常少,网络消耗会占到48.5%,那时消耗最多的可能就是算力成本,因为做虚拟对GPU的消耗非常大。在边缘消耗的网络比较低,因为靠近用户所以不需要那么宽的带宽。但是,它会消耗大量计算,约82%的成本会花在计算上。所以现在通过实时互动,我们的GPU算力、AI算力大幅度提升,这对算力的消耗是非常大的。其实我们在技术突破上有非常多的方向和研究。

计算架构

实时互动的计算架构会放在哪儿?我们认为未来会放在云端。因为手机最大的问题是,它的算力始终赶不上PC。所以未来这种互动视频的算力还是会集中在云端,目前业界已经基本认可在云端渲染的可能性了。从功耗、操控时延、画质、存储空间来看,未来很多互动视频的渲染和互动都会发生在云端,同时这样还可以解决手机存储空间过大的问题。现在下载一个游戏动辄要多个G,会占据很大的内存空间,未来这部分的算力和存储都会发生在云端。

在去年底举行的IEDM 2021大会上,Meta Reality Labs的首席科学家迈克尔·亚伯拉什提出,为了将科幻作品所描述的AR眼镜变成现实,我们需要一种全新的计算架构。

Meta不认为当前的技术或任何一家厂商能够实现真正的AR眼镜形态。现在,AR/VR存在的一个很大问题是,设备能源消耗太大,影响便携性。就算是目前市面上最优秀的AR设备HoloLens 2和Magic Leap 2,它们离眼镜形态依然遥远,而且相当巨型,无法整天穿戴。

亚伯拉什提出了一种可以满足真正AR眼镜形态需求的全新计算架构思考,具体而言,未来的计算架构会往以下三个方向发展:1.紧盯能耗走向,2.在最意想不到的地方执行计算,3.通过Domain-Specific传感器执行更复杂的计算。

当互动3D视频应用走向云端后,需要全新的3D基础设施。今年四五月份谷歌做了一个沉浸式3D实景导航地图,加入了更多沉浸或AR体验功能。它采用的是NeRF“神经渲染”的技术,通过简单的照片叠加+神经渲染,就可以模拟出真实的3D效果,而且它可以把渲染3D图形直接发到任何一台手机上观看,实现移动端的沉浸式体验。这代表了未来算力走向云端的变化。

网络

除了算力上的变化,未来的网络也需要重构,最重要的是解决“弱网的适应性”和“万人同服”的诉求。

其实,端到端需要支持100ms的延迟,在网络需求里,在中心云处理的时间大概需要3-5ms,骨干网需要40-100ms,骨干网不太可能长距离消除,所以需要用到边缘计算的方法和其他方法来实现。未来不可能期待网络是最好的,所以弱网需要做出改变,包括传输协议,面向多流多场景做新的常数,还有3D视频、资源、媒体等方面的调整。

此外,网络还要支持“万人同服”,处理100个人的互动是一种方式,但是处理1万个人同时工作、同时在线、同时互动,它的难度是指数级上升。这相应也会带来很多架构性的变化。“以太网标准之父”梅特卡夫提出,网络的价值与连接用户的数量成正比。现在做到万级,如果未来要做到千万级亿万级,可想而知会发生很多诉求上的变化。

辅助式AI

未来大量的内容将由AI辅助生成,占比可能会从现在的1%上升到50%。现在很多的新闻不是由人工生成,而是自动生成的。其实现在直播里的P图就是用到了辅助式AI,未来它会越来越多。媒体内容自动生成、P图、场景、数字人都会由大量AI生成。

云原生物理引擎架构

未来面向云原生会有很多架构变化。现在的引擎大部分都是把3D变成2D推到每个人的手机上,这种渲染是针对每个人来做单独渲染,所以消耗的量非常大,不适合上云端。上了云之后可以做什么?我们相同的场景可以做共享,这就是一次计算、物理粒子表面重建去重、粒子表面Mesh重建。我们存很多相同的文件,只需要存一份,最后拷出来的时候一个都不会丢失,图象压缩也是去重。单客户构建、多人共享也可以在云端实现。如果有1000万个人,上了云之后,我们不需要同时给他们做渲染,只需要把其中不同的部分做渲染就可以了,相同部分的渲染可以直接共享。

数字人

现在基本上到处都在用数字人。未来,数字人应用会越来越多。要把数字人做好,需要满足三个要素:“皮”“形”“魂”。“皮”是皮肤、装饰。要把皮做好,实际要把参数、模型做好。做“形”也是如此,要做数字化人体库。SAE公司做了很多全身扫描的技术,未来的数字人建模里,数字和模型是密切相关的,模型越细化,做出来的人的动作就越好,形态也越逼真。“魂”包括说话。现在很多直播里的配音已经不是由人来配,而是AI在说话,还会搭配表情。要想把魂做好,就要在如何发音,如何做动态捕捉,如何合成语言能力,肢体等方面,形成大量数据库,包括肢体库、运动库等。这也是未来的变化。

总的来讲,未来,云将成为整个“元宇宙世界”的运行平台,这里有运行自动伸缩的云世界,在虚实世界里也会有很多真实的世界,所以未来云是整个Metaverse的世界。

#03

华为云助力产业进入元宇宙时代

最后介绍一下,华为云在助力产业进入元宇宙时代的一些探索和实践。

通过我们的华为云MetaStudio数字内容生产线,各行业用户都可以便捷地在云上生产数字内容,开发3D应用,打造虚拟演唱会、虚拟展会、办公协作、工业数字孪生等,同时支撑海量用户的实时互动,让虚拟世界和现实世界无缝融合。

目前,华为云已经上线了全流程场景化的数字人服务,可以快速生成一个数字人。在数字人生成服务中,我们提供风格化数字人,写实数字人和真人3D视频制作等服务。

数字人有很多种,第一种是风格化数字人,也就是卡通类型的数字人,它们通常用于数字人直播、虚拟社交等行业场景。这种制作比较简单,只需要把照片上传上去就可以,通过各种识别、集合形变、素材匹配就可以形成风格化的数字人。

还有一种是比较难的写实化数字人,通常用于综艺、影视等行业中,对数字人各方面的真实性要求都更高。写实数字人的制作过程包括光笼扫描,几何生成、纹理补全、材质生成、素材匹配等环节。光笼里还提供3D视频制作云服务,包括整个系统搭建,素材采集上云,视频生成等,它的速度非常快,基本上一两天就实现了一站式的数字人制作。

这些数字人可以应用到直播带货、新闻播报、智能客服等不同行业的场景。最典型的场景是直播。在数字人直播服务中,它主要讲究的是真人的还原度,在直播平台上主要是动作的捕捉。原来做动捕的时候有专门的笼子,里面有几十台摄像机,现在我们只要一个摄像头就可以把人的动作、检测实时效果优化。原来很专业的事情现在变得很简单。

此外,刚才我所提到的数字人服务,都开放了对应的API,开发者可以直接调取对应的数字人生成服务API,快速创建不同类型的数字人。