随着大模型和生成式人工智能的发展,国内外公司逐步推动该技术在各种应用程序中的采用。但其耗电量大的问题引起了人们的担忧,毕竟类似的电力消耗已在加密货币领域引发了广泛批评。

本周,荷兰阿姆斯特丹自由大学的数据科学家Alex de Vries就AI耗电量的问题发表了一项研究,研究中指出,到2027年,AI数据中心的电力需求可能达到每年85-134太瓦时 (TWh)。这与阿根廷、荷兰和瑞典各自一年的用电量类似,约占全球当前用电量的0.5%。

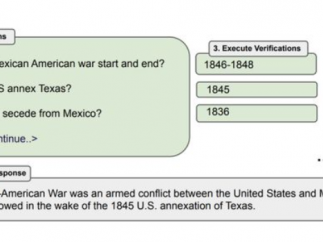

以科技巨头谷歌为例,谷歌已经将生成式人工智能纳入公司的电子邮件服务中,并正在测试利用人工智能为其搜索引擎提供动力。目前该公司每天处理多达90亿次搜索。

如果谷歌每次搜索都使用人工智能,每年大约需要29.2TWh 的电力,相当于爱尔兰一年的用电量。

Alex de Vries还计算了Nvidia预计今年交付的100,000台AI服务器的潜在能耗。这些服务器满负荷运行时,每年可能会消耗5.7至8.9太瓦时的电力。与数据中心历史估计的年用电量205 TWh相比,这“几乎可以忽略不计”。

即便如此,如果人工智能的普及率继续飙升并且供应链限制放松,用电量可能会急剧增长。到2027年,如果Nvidia出货150万台AI服务器,每年将消耗85.4至134.0 TWh的电力,这可与当今比特币的能源需求相媲美。

而且人工智能的能源足迹并不会随着训练而结束。德弗里斯的分析表明,当该工具投入工作(根据提示生成数据)时,每次该工具生成文本或图像后,它也会使用大量的计算能力,从而消耗大量的能源。例如,ChatGPT每天的运行费用可能为564 MWh。

专家表示,巨大的碳足迹应该迫使我们重新考虑在人工智能领域进行的巨额投资,特别是像OpenAI和Google这样科技巨头的高能耗运营方式。佛罗伦萨大学的助理教授表示,也许我们需要适度减速,开始应用我们已经拥有的解决方案。不仅要提高模型的准确性和速度,还要深入思考我们在环境资源方面的损耗。

此前,加州州长Gavin Newsom签署两项重要的气候披露法律,迫使OpenAI和Google等大约10,000家公司披露到2026年它们产生了多少碳。该规定在美国尚属首例,这些法律也可能会产生超出州界的影响。

即使监管机构加强了审查,该领域仍在很大程度上进行自我管理,人工智能公司可能会继续消耗大量精力来维持其模型的运行。

然而,由于当前的高能耗,降低这些成本具有经济激励,技术进步是必不可少的。考虑到其巨大的环境足迹,任何突破都不能来得太晚。AI领域的可持续发展需要更多的创新和关注,以应对不断增长的电力需求。