2023年3月22日,来自UC伯克利的研究人员基于Instruct-Pix2Pix,提出了一种使用文本指令编辑3D场景的方法——Instruct-NeRF2NeRF。其工作原理是在优化底层场景的同时迭代编辑输入图像,从而形成一个遵循编辑指令的优化的三维场景。Instruct-NeRF2NeRF的出现使得3D内容的自动化、智能化生产以及全民化、便捷化应用的可能性进一步提升,我们认为3D应用相关产业趋势值得关注。

Abstract

摘要

Instruct-NeRF2NeRF提出了使用文本指令编辑NeRF场景的方法,实现了对3D场景的快速重建。相较于传统3D编辑,Instruct-NeRF2NeRF的最大亮点在于将Instruct-Pix2Pix同NeRF(Neural Radiance Field)结合起来,在提高3D场景编辑效率的同时,大幅减弱了不同视角下场景变换的割裂感和虚假感。

3D场景编辑的技术突破进一步完善了元宇宙的底层技术支撑。Instruct-NeRF2NeRF的出现使我们看到了低成本、低门槛、高质量的3D场景构建技术的可能。我们认为该技术作为构建元宇宙的基础设施,有望打破3D场景制作流程复杂的现状,从而满足元宇宙对于大量3D内容的刚性需求。

AI赋能下,3D内容生产实现增效降本,有望推动行业应用的发展。效率低、成本高是过往制约3D内容生产的核心问题。我们认为成本和应用门槛的下降,有望促进3D内容在游戏、电商、虚拟人、MR和XR等领域的持续渗透,逐步使得普通消费者可以直接参与到3D内容的创作和消费中。

技术进展不及预期,行业竞争加剧,商业化落地节奏不及预期。

Instruct NeRF-2-NeRF简介

Instruct-NeRF2NeRF是一种用文本指令编辑3D场景的算法。在这篇论文中,作者创新性地将InstructPix2Pix同NeRF(Neural Radiance Field)结合起来,在提高对3D场景编辑效率的同时,大幅减弱了场景变换的割裂感和虚假感。

Instruct-NeRF2NeRF的基本思想是使用图像条件下的扩散模型Instruct-Pix2Pix来迭代编辑输入图像,同时优化底层场景,从而形成遵循编辑指令的优化的三维场景。Instruct-Pix2Pix作为生成模型,可以根据文本描述生成图像;工作原理是首先用随机噪声初始化图像,然后根据文本描述迭代更新图像;其对更新规则的设计旨在使图像与用户输入的文字描述的匹配度增加。

Instruct-NeRF2NeRF具体实现步骤:首先,输入图像并经过训练视角下的场景渲染;其次,由Instruct-Pix2Pix给定全局文本指令对其进行编辑;再次,训练数据集的原有图像被替换成编辑过的图像;最后,将多角度下的图像输入NeRF训练得到神经辐射场模型,并渲染出任意视角下的清晰图像。这一过程将不断重复,直到完成所需的编辑。

Instruct-NeRF2NeRF已经被证明可以有效地编辑各种3D场景,包括室内场景、室外场景,甚至是人脸。此外,它还可以用来为增强现实和虚拟现实应用创建虚拟世界。以下是Instruct-NeRF2NeRF的一些使用案例:

► 虚拟现实和增强现实:Instruct-NeRF2NeRF可用于为增强现实和虚拟现实应用创建虚拟世界。例如,Instruct-NeRF2NeRF可以用来创建一个用户家中某个房间的虚拟世界,然后用户可以使用增强现实技术将虚拟世界中的物体投影到真实世界中。

► 三维建模:Instruct-NeRF2NeRF可以用来创建物体或场景的三维模型。例如,用户可以使用Instruct-NeRF2NeRF创建一个汽车的3D模型,然后可以用这个3D模型为用户的汽车创建一个虚拟展厅。

► 动画:Instruct-NeRF2NeRF可以用来创建物体或场景的动画。例如,用户可以使用Instruct-NeRF2NeRF创建一个球正在弹跳的动画,然后用户可以用这个动画来创建一个视频游戏。

► 艺术:Instruct-NeRF2NeRF可以用来实现艺术体验,如绘画或雕塑。例如,用户可以用Instruct-NeRF2NeRF创造一幅风景画,然后可以用这幅画创造一个虚拟现实体验。

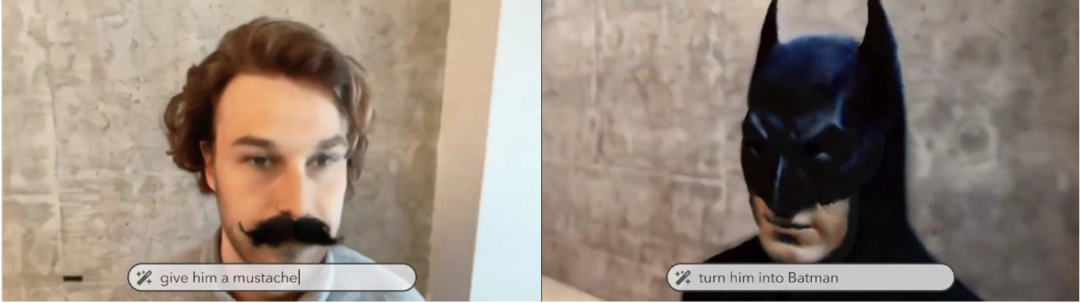

图表1:通过输入文字,即可实现用自然语言修改3D模型

资料来源:Instruct-NeRF2NeRF官方Blog,中金公司研究部

什么是NeRF?

NeRF (Neural Radiance Fields) 是一种新颖的AI技术,用于将2D图像合成高质量的3D场景。它的基本思想是将3D场景表示为一个连续的、可微分的函数,再由该函数将3D坐标映射到颜色和密度值。该函数使用神经网络建模,通过神经网络从不同视角捕捉场景的2D图像,并在这一数据集上进行训练从而实现对3D场景的重建。

NeRF的关键创新在于使用辐射场来隐式表示场景,有别于传统三维重建将场景表示为网格等显式表达。辐射场是一个将3D点和观察方向映射到该点在该方向上发出的辐射(颜色和亮度)的函数。基于这一函数,NeRF可以从任意视角生成高质量且逼真的3D场景图像。

训练NeRF 模型需要从不同视角的场景中收集大量的2D图像。这些图像用于估计摄像机的位置,并使用结构从运动技术中提取深度信息。然后,所提取的深度信息用于生成训练数据,包括3D点和与之相应的RGB值。在输入这些数据后,该神经网络经过训练从而能够预测场景中任何3D点的辐射值。

在推断期间,NeRF接收观察方向作为输入,并生成相应的场景图像。为了生成图像,NeRF 需要先从摄像机位置向场景采样一组光线。对于每条光线,NeRF使用神经网络估计沿光线的一组点的辐射值,然后将估计的辐射值沿着光线积分,从而计算相应像素在输出图像中的最终值。

NeRF有许多潜在的应用领域,包括虚拟和增强现实、计算机图形学和机器人技术。例如,NeRF可用于生成难以或不可能使用传统成像技术捕捉的场景的逼真图像,如具有复杂照明或遮挡的场景。此外,NeRF也可以基于少量的2D图像集生成复杂的3D场景,从而在机器人技术和自主导航中有所应用。

英伟达的开源NeRF技术

Nvidia的Instant-NeRF是一个加速NeRF训练和推理的开源库。它基于NeRF的基本思想,使用深度神经网络对辐射场进行建模,并使用渐进式渲染技术生成高质量的3D场景。与传统NeRF不同,Instant-NeRF使用Fourier Featurization技术,将位置和方向信息嵌入到神经网络的隐藏层中,从而显著减少了网络的参数数量和计算成本,实现了实时渲染效果。

Instant-NeRF的开源使得该算法可以广泛地应用于计算机图形学、增强现实和虚拟现实等领域。此外,Instant-NeRF 还支持对不同类型数据集进行训练和推理,由此提高其对各种应用场景的适用性。由于其高效和高质量的渲染结果,Instant-NeRF在游戏开发、影视制作和工业设计等领域均具有广泛的应用前景。

开源使得任何人都可以访问并使用Instant-NeRF。英伟达的Instant-NeRF是非商用的,使用的是Nvidia Source Code License-NC。开放的开发模式下,研究人员和开发人员可以依据自身需求,自由地修改和扩展Instant-NeRF,从而促进了NeRF技术的发展和普及,使更多人能够受益于这项重要的技术进步。

图表2:英伟达开源的Instant-NeRF只需要几张照片便可以构建出3D场景

资料来源:Nidia Tech Blog,中金公司研究部

图表3:Instant-NeRF算法以3D方式重现Andy Warhol公布拍立得相片的经典时刻

资料来源:英伟达官网,中金公司研究部

什么是Instruct-Pix2Pix?

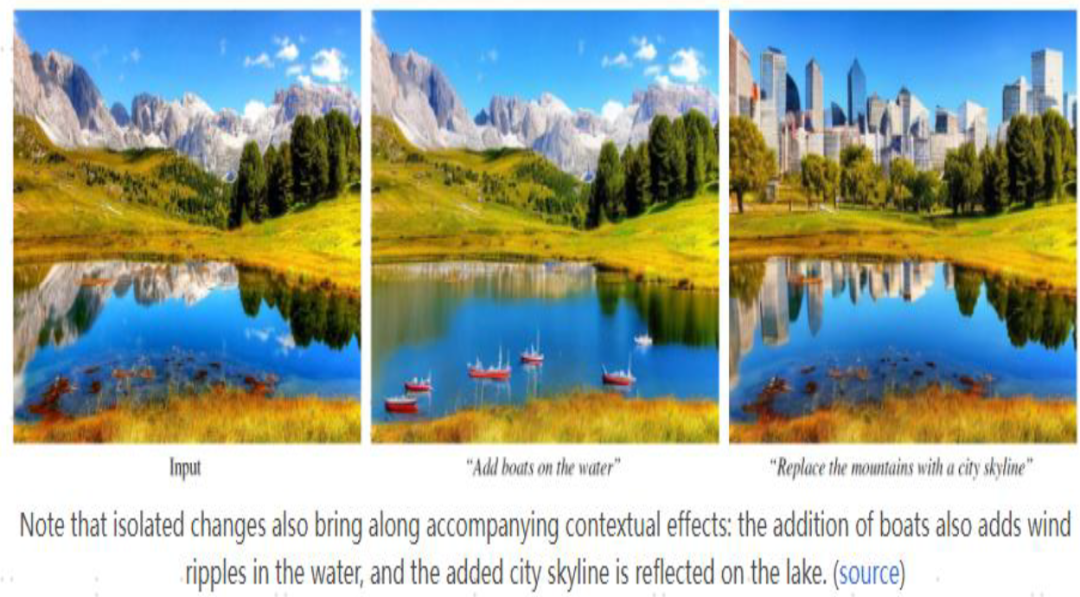

Instruct-Pix2Pix是一个有条件的文本引导扩散模型,可以根据人类的自然语言指令来编辑图像。在用户给定输入图像和编辑图像的自然语言指令后,Instruct-Pix2Pix通过直接在前向传播中执行图像编辑,便可以快速生成编辑后的图像。

图表4:用Instruct-Pix2Pix 以自然语言修改图片:在湖面上加上船,或者将群山换为城市

资料来源:Instruct-Pix2Pix 官方Blog,中金公司研究部

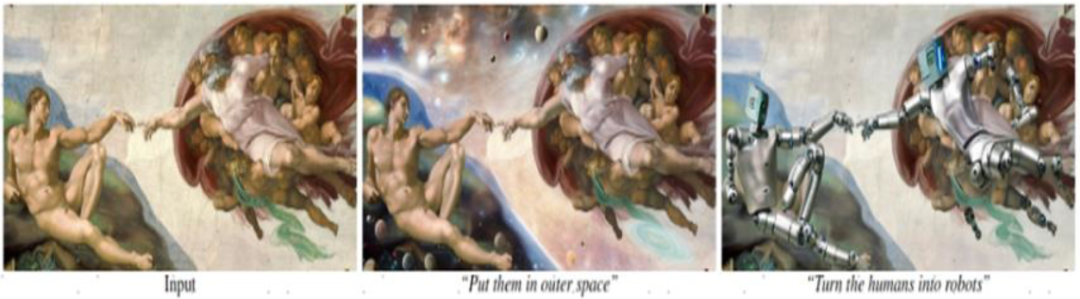

图表5:用Instruct-Pix2Pix 以自然语言修改图片:将人类换成机器人

资料来源:Instruct-Pix2Pix 官方Blog,中金公司研究部

为生成训练所需的数据集,Instruct-Pix2Pix的作者结合了大型语言模型(GPT-3)和文本到图像模型(Stable Diffusion)两个模型。首先,作者使用GPT-3生成文本三联体:(a)描述图像的标题;(b)编辑指令;(c)描述编辑后的图像的标题。其次,他们使用Stable Diffusion和Prompt-to-Prompt将成对的标题(编辑前/编辑后)转为成对的图像。最后,基于海量的配对数据,作者对Stable Diffusion model进行训练,并做以微调,从而诞生出Instruct-Pix2Pix。

Instruct-Pix2Pix拥有泛化能力,能够对任何图片根据自然语言描述进行修改。相较SDEdit、Text2Live等过往模型,Instruct Pix2Pix经其作者比较,在图像编辑过程中对图像主体的保留程度以及编辑效果均有明显优势。此外,Instruct-Pix2Pix对于512x512像素的图片,修改时间不超过10秒,生成速度尚可。

Instruct-NeRF2NeRF模型的局限性

Instruct-NeRF2NeRF为将NeRF与Instruct-Pix2Pix结合所产生的模型,因此延续了Instruct-Pix2Pix的诸多局限:不能更改视角或空间布局;不能对图片做太大的变换;难以单独分离物体。

本文摘自:2023年4月13日已经发布的《中金前沿论文导读:元宇宙复兴的信号?Instruct-NeRF2NeRF & Pix2Pix三维领航》