来源:Techcrunch

编译:巴比特

人工智能(AI)似乎出现在现代生活的每一个角落,从音乐和媒体到商业和生产力,甚至是约会。有太多东西很难跟上。本文将介绍 AI 从最新的大发展到你需要知道的术语和公司的一切,以便在这个快速发展的领域了解最新状态。

首先,什么是人工智能?

人工智能,也称为机器学习(Machine Learning),是一种基于神经网络的软件系统,这种技术实际上是几十年前开创的,但最近由于强大的新计算资源而蓬勃发展。目前,AI 已经实现了有效的语音和图像识别,以及生成合成图像和语音的能力。研究人员正在努力使人工智能能够实现浏览网页、订票、调整食谱等功能。

但是,如果你担心黑客帝国式的机器崛起——不必担忧。我们稍后再谈这个问题!

本篇 AI 指南包含两个主要部分:

首先,你需要了解的最基本概念以及最近的重要概念。

然后,概述 AI 的主要参与者及其重要性。

AI 101

图片来源: Andrii Shyp / Getty Images

关于 AI 的一个疯狂之处是,尽管其核心概念可以追溯到 50 多年前,但在最近之前,即使是精通技术的人也很少熟悉其中的概念。因此,如果你感到迷茫,请不要担心——每个人都是如此。

有一件事我们要预先明确:虽然它被称为“人工智能”,但这个词有点误导。目前智能没有统一的定义,但这些系统所做的绝对更接近于计算器而不是大脑,只是这个计算器的输入和输出更加灵活。人工智能可能就像“人造椰子”(Artificial Coconut)——它是模仿智能。

以下是在任何有关 AI 的讨论中都会找到的基本术语。

神经网络

我们的大脑主要由称为神经元的相互连接的细胞构成,它们相互啮合形成执行任务和存储信息的复杂网络。自 20 世纪 60 年代以来,人们一直在尝试在软件中重建这个惊人的系统,但所需的处理能力直到 15-20 年前才被广泛应用,当时的 GPU 让数字定义的神经网络蓬勃发展。

从本质上讲,它们只是很多点和线:点是数据,线是这些值之间的统计关系。就像在大脑中一样,这可以创建一个多功能系统,快速接收一个输入,通过网络传递并产生一个输出。这个系统被称为模型。

模型

模型是接受输入并返回输出的实际代码集合。与统计模型或模拟复杂自然过程的建模系统在术语上的相似性并非偶然。在 AI 中,模型可以指像 ChatGPT 这样的完整系统,或者几乎任何 AI 或机器学习结构,无论它做什么或产生什么。模型有各种大小,这意味着它们占用多少存储空间以及它们运行需要多少计算能力。而这些都取决于模型的训练方式。

训练

为了创建一个 AI 模型,构成系统基础的神经网络会暴露在所谓的数据集或语料库中的一堆信息中。在这样做的过程中,这些巨大的网络创建了该数据的统计表示。这个训练过程是计算最密集的部分,这意味着它需要在巨大的高功率计算机上花费数周或数月的时间。这样做的原因不仅是网络复杂,而且数据集可能非常大:必须分析数十亿个单词或图像,并在巨大的统计模型中给出表示。另一方面,一旦模型完成训练,它在使用时可以小得多,要求也低得多,这个过程称为推理(Inference)。

图片来源:谷歌

推理(Inference)

当模型真正发挥作用时,我们称之为推理,这个词的传统含义非常多:通过对可用证据的推理来陈述一个结论。当然,这不完全是“推理”,而是在统计学上将它摄取的数据中的点联系起来,实际上是预测下一个点。例如,说“完成以下序列:红色、橙色、黄色……”它会发现这些词对应于它所摄取的列表的开头,即彩虹的颜色,并推断下一个项目,直到它产生了该列表的其余部分。

推理的计算成本通常比训练低得多:可以把它想象成浏览卡片目录而不是组装它。大型模型仍然必须在超级计算机和 GPU 上运行,但较小的模型可以在智能手机或更简单的设备上运行。

生成式人工智能

每个人都在谈论生成式 AI,这个广义术语仅指生成原始输出(如图像或文本)的 AI 模型。一些 AI 进行总结,一些进行重组,一些进行识别等等——但真正生成某些东西(无论它是否“创造”是有争议的)的 AI 现在特别流行。请记住,仅仅因为 AI 生成了某些东西,并不意味着它是正确的,甚至不意味着它反映了现实!只是它在你要求之前并不存在,就像一个故事或一幅画。

现在的热门词汇

除了基础知识,以下是 2023 年年中最相关的 AI 术语。

大型语言模型(LLM)

大型语言模型是当今最具影响力和用途最广泛的人工智能形式,大型语言模型是在几乎所有构成网络的文本和大部分英语文学作品上进行训练的。摄取所有这些会产生一个巨大的基础模型(继续阅读)。LLMs 能够用自然语言交谈和回答问题,并模仿各种风格和类型的书面文件,ChatGPT、Claude 和 LLaMa 等工具就证明了这一点。

尽管这些模型无疑令人印象深刻,但必须牢记它们仍然是模式识别引擎,当它们回答问题时,就是试图完成它已识别的模式,无论该模式是否反映现实。LLMs 经常在它们的答案中产生幻觉,我们很快就会谈到。

基础模型(Foundation Model)

在巨大的数据集上从头开始训练一个巨大的模型既昂贵又复杂,所以你不想做得比你必须做的更多。基础模型是需要超级计算机才能运行的从头开始的大型模型,但通常通过减少参数的数量,它们可以被缩减到更小的容器中。你可以将这些视为模型必须处理的总点数,如今它可以达到数百万、数十亿甚至数万亿。

微调

像 GPT-4 这样的基础模型很聪明,但它在设计上也是一个通才——它吸收了从狄更斯到维特根斯坦再到龙与地下城规则的所有内容,但如果你想让它根据你的简历写一封求职信,这些都是没有用的。幸运的是,可以通过使用专门的数据集对模型进行一些额外的训练来对模型进行微调。例如,碰巧有几千份工作申请。这让模型更好地了解如何在该领域帮助用户,而不会丢弃它从其余训练数据中收集的一般知识。

从人类反馈中强化学习(RLHF),是一种你会经常听到的特殊微调——它使用人类与 LLM 交互的数据来改善其沟通技巧。

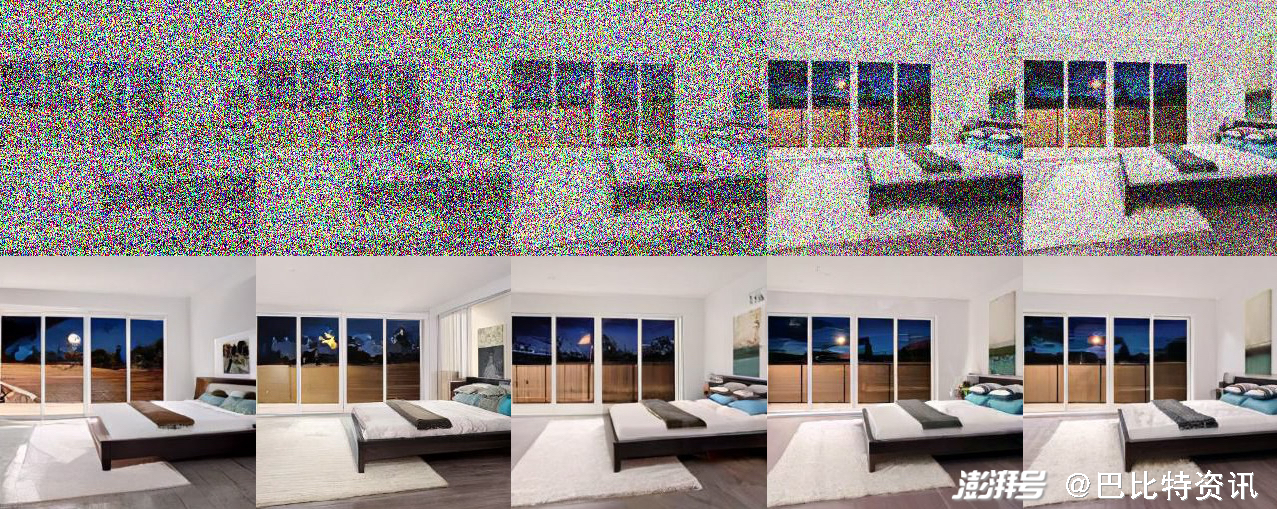

扩散(Diffusion)

从一篇关于高级后扩散技术的论文中,你可以看到如何从非常嘈杂的数据中再现图像。

图像生成可以通过多种方式完成,但迄今为止最成功的是扩散,这是 Stable Diffusion、Midjourney 和其他流行的生成 AI 的核心技术。通过向扩散模型展示图像来训练扩散模型,这些图像通过添加数字噪声逐渐退化,直到原始图像一无所有。通过观察这一点,扩散模型也学会了反向执行该过程,逐渐向纯噪声添加细节以形成任意定义的图像。我们已经开始在图像上超越这一点,但该技术是可靠的并且相对容易理解,所以它会很快被淘汰。

幻觉(Hallucination)

最初这是一个训练中的某些图像滑入不相关输出的问题,例如由于训练集中狗图片的过度流行,建筑物似乎变得由狗组成。现在据说人工智能会产生幻觉,因为它的训练集中没有足够或相互冲突的数据,它只是编造一些东西。

一个被要求创造原创或甚至衍生艺术的 AI 正在产生幻觉。例如,一个 LLM 可以被告知以 Yogi Berra 的风格写一首情诗,它会很乐意这样做——尽管这样的东西在它的数据集中并不存在。但是当需要一个事实答案时,这可能是一个问题;模型将自信地呈现出一半真实、一半幻觉的反应。目前除了自己检查之外没有简单的方法来判断哪个是哪个,因为模型本身实际上并不知道什么是“真”或“假”,它只是试图尽可能地完成一个模式。

AGI 或强人工智能

通用人工智能(AGI)或强人工智能,并不是一个真正定义明确的概念,但最简单的解释是,它是一种足够强大的智能,不仅可以做人们所做的事情,还可以像我们一样学习和改进自己。有些人担心,这种学习、整合这些想法、然后更快地学习和成长的循环将是一种自我延续的循环,会导致一个无法约束或控制的超级智能系统。一些人甚至提议推迟或限制研究以防止这种可能性。

这是一个可怕的想法。而像《黑客帝国》和《终结者》这样的电影已经探索了如果人工智能失控并试图消灭或奴役人类可能会发生的情况。但这些故事并不以现实为基础。我们在 ChatGPT 等事物中看到的智能外观令人印象深刻,但与我们与“真实”智能相关联的抽象推理和动态多领域活动几乎没有共同之处。

尽管预测未来的发展几乎是不可能的,但把 AGI 想象成星际太空旅行在理解上可能会有所帮助:我们都理解这个概念,并似乎也在朝着这个方向努力,但与此同时,我们离实现它还有很长的路要走。正如 AGI,由于需要巨大的资源和基础科学进步,没有人会突然偶然地完成它!

思考 AGI 很有趣,但没有必要自找麻烦,因为正如评论员指出的那样,尽管 AI 有其局限性,但它已经在今天带来了真实而重大的威胁。没有人想要天网,但你不需要配备核武器的超级智能来造成真正的伤害:今天人们正在失去工作并上当受骗。如果我们不能解决这些问题,我们还有什么机会对抗 T-1000?

人工智能领域的顶级玩家

OpenAI

图片来源: Leon Neal / Getty Images

如果 AI 中有一个家喻户晓的名字,那就是 OpenAI。顾名思义,OpenAI 是一个打算进行研究并或多或少公开提供结果的组织。此后,它重组为一家更传统的营利性公司,通过 API 和应用程序提供对 ChatGPT 等高级语言模型的访问。它由 Sam Altman 领导,他是一位技术派的亿万富翁,尽管如此,他还是对人工智能可能带来的风险发出了警告。OpenAI 是 LLMs 领域公认的领导者,但也在其他领域进行研究。

微软

如你所料,微软在 AI 研究方面做出了应有的贡献,但与其他公司一样,或多或少未能将其实验转化为主要产品。它最明智的举动是尽早投资 OpenAI,这使它与该公司建立了独家长期合作伙伴关系,该公司现在为其 Bing 对话代理提供支持。尽管它自己的贡献较小且不太直接适用,但该公司确实拥有相当大的研究实力。

谷歌

谷歌以其登月计划而闻名,不知何故错过了人工智能的机会,尽管它的研究人员确实发明了直接导致今天人工智能爆炸的技术:变压器。现在它正在努力开发自己的 LLMs 和其他代理,但在过去十年花费大部分时间和金钱来推动过时的人工智能“虚拟助手”概念之后,它显然正在追赶。首席执行官 Sundar Pichai 多次表示,公司在搜索和生产力方面坚定支持 AI。

Anthropic

在 OpenAI 偏离开放性之后,Dario 和 Daniela Amodei 离开了它,创办了 Anthropic,意在填补一个开放和道德上考虑周全的 AI 研究组织的角色。凭借他们手头的现金数量,他们是 OpenAI 的有力竞争对手,即使他们的模型(如 Claude)还没有那么受欢迎或知名。

图片来源: Bryce Durbin / TechCrunch

Stability

有争议但不可避免的是,Stability 代表了“随心所欲”的 AI 实施开源流派,它收集了互联网上的所有内容,并在你拥有运行它的硬件的情况下,免费提供它训练的生成 AI 模型。这非常符合“信息想要自由”的理念,但也加速了道德上可疑的项目,如生成色情图像和未经同意使用知识产权(有时同时发生)。

埃隆·马斯克(Elon Musk)

马斯克也不例外,他直言不讳地表达了他对失控的人工智能的担忧,以及在他早期为 OpenAI 做出贡献并且朝着他不喜欢的方向发展之后的一些酸葡萄情绪。虽然马斯克不是这方面的专家,但像往常一样,他的滑稽动作和评论确实引起了广泛的反响(他是上述“人工智能暂停”信件的签署人),而且他正试图建立自己的研究机构。